Más allá del modelo: Gemelos digitales con IA predictiva

Gemelos digitales con IA: de pilotos a producción real. Aprende cómo predicen fallas, mejoran productividad y transforman industrias.

En abril de 1970, cuando la misión Apollo 13 enfrentó una emergencia crítica a 320,000 kilómetros de la Tierra, los ingenieros de la NASA no podían subir a reparar nada. Lo que sí tenían era una réplica exacta de la nave en Houston. Esa simulación terrestre les permitió probar soluciones, anticipar problemas y salvar a la tripulación. Era, en esencia, el primer gemelo digital de la historia.

Más de cinco décadas después, ese concepto ha evolucionado radicalmente. Los gemelos digitales de hoy no son réplicas estáticas sino sistemas vivos que aprenden, se adaptan y predicen comportamientos futuros. La diferencia fundamental está en la capacidad de procesamiento continuo: millones de puntos de datos fluyendo en tiempo real desde sensores IoT, alimentando algoritmos de aprendizaje que detectan patrones invisibles y anticipan fallas con días de ventaja.

De la simulación estática al sistema inteligente

El salto ocurre cuando estos modelos dejan de ser proyectos experimentales y se convierten en componentes arquitectónicos de operaciones críticas. Ya no hablamos de simulaciones que corren una vez al mes, sino de réplicas digitales que procesan telemetría en edge, ejecutan inferencias de IA y disparan automatizaciones sin intervención humana.

Los números respaldan esta transformación: según datos del Digital Twins Strategic Intelligence Report 2025, el mercado global de gemelos digitales alcanzará $154.3 mil millones para 2030, impulsado por la convergencia de IoT, cloud flexible y analítica avanzada. Los casos de uso se han diversificado desde el monitoreo remoto de turbinas eólicas hasta el modelado de interacciones moleculares en farmacéutica, pasando por diseño generativo 3D y optimización de redes de distribución.

Para esto, cada gemelo digital inteligente parte de un stack tecnológico que incluye:

- Capa de sensores IoT y edge computing: Capturan telemetría en milisegundos (temperatura, vibración, latencia, throughput) con preprocesamiento local que reduce la carga en la red

- Infraestructura cloud y data lakes: Procesan streams de datos mediante arquitecturas como Kafka o Kinesis, almacenando petabytes de información histórica

- Modelos predictivos de IA/ML: Desde series temporales (LSTM, Prophet) hasta detección de anomalías (Isolation Forest, Autoencoders) y forecasting multivariable

- Capa de visualización y orquestación: Dashboards interactivos con trazas distribuidas y capacidad de simular escenarios what-if antes de implementar cambios

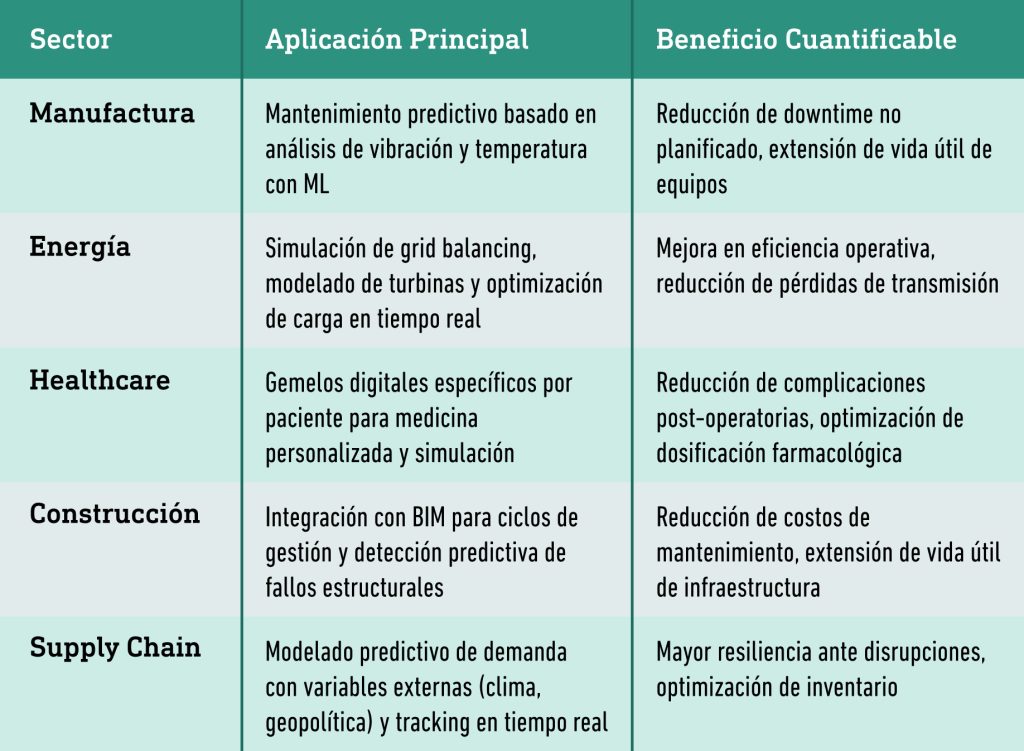

Aplicaciones reales: Del laboratorio al negocio

Lo interesante es que esta tecnología ya no es exclusiva de grandes corporaciones con presupuestos millonarios. Diferentes sectores la están adoptando y obteniendo resultados medibles:

Datos entran, datos salen: Observabilidad como clave

Aquí está el punto crítico que muchas organizaciones pasan por alto: un gemelo digital solo es tan preciso como los datos que lo alimentan, haciendo indispensables sistemas de monitoreo confiables. Por eso la observabilidad moderna va mucho más allá del monitoreo tradicional. Necesitas visibilidad contextualizada que abarque aplicaciones, infraestructura y experiencia del usuario final, todo correlacionado en tiempo real.

Las arquitecturas avanzadas implementan los tres pilares fundamentales de observabilidad. Las métricas proporcionan agregaciones cuantitativas como CPU, memoria y latencia p99, detectando degradaciones antes de que escalen. Los logs estructurados capturan eventos discretos con contexto semántico completo: request ID, user session, metadata del service mesh. Las trazas distribuidas siguen transacciones end-to-end a través de microservicios, APIs y componentes de infraestructura, mapeando cada interdependencia.

Esta telemetría es lo que convierte un modelo estático en un gemelo digital inteligente. Permite detectar anomalías cuando los parámetros se desvían más de 2 desviaciones estándar de su media histórica, correlacionar automáticamente eventos entre capas físicas y digitales, y reducir el MTTR hasta un 80%. Los modelos predictivos de regresión y clasificación pueden entonces anticipar degradaciones antes de que afecten la operación.

Los desafíos de la implementación

La interoperabilidad sigue siendo el principal obstáculo técnico. Para que gemelos digitales de diferentes proveedores se comuniquen efectivamente, necesitas estandarización en data schemas, protocolos de comunicación y APIs abiertas.

Iniciativas como el Digital Twin Consortium trabajan en especificaciones comunes, pero el ecosistema sigue fragmentado. Cada sensor IoT, cada API expuesta y cada flujo de datos representa una superficie de ataque potencial. La seguridad debe diseñarse desde el inicio: autenticación mutual TLS, cifrado end-to-end, gestión de secretos con vaults y políticas de least privilege en todos los niveles.

Y luego está la complejidad operacional. Mantener pipelines de datos funcionando 24/7, reentrenar modelos cuando pierden precisión, orquestar respuestas automatizadas: todo esto requiere equipos multidisciplinarios con expertise en DevOps, MLOps y arquitectura distribuida.

La era de la convergencia

Este 2025 está marcando un punto de inflexión. Los gemelos digitales ya están convergiendo con spatial computing y metaversos industriales, habilitando inspecciones inmersivas de infraestructura crítica en 3D. En climate modeling, replican sistemas atmosféricos completos para predecir fenómenos extremos con mayor precisión. Las agencias espaciales continúan usando esta tecnología para validar sistemas antes del lanzamiento, exactamente como en Apollo 13, pero con capacidades exponencialmente superiores.

El patrón es claro: las organizaciones que han logrado migrar de pruebas de concepto a implementaciones productivas están cosechando resultados. No solo optimizan operaciones actuales, sino que construyen capacidades predictivas que reducen el riesgo operacional y aceleran el time-to-market de nuevas innovaciones.

Pero esta transición exitosa tiene un requisito fundamental: visibilidad continua del rendimiento de las aplicaciones que alimentan estos gemelos digitales. Soluciones como Ikusi Monitoreo del rendimiento de aplicaciones (APM) permiten detectar degradaciones antes de que afecten la precisión de los modelos, correlacionar eventos entre capas de infraestructura y aplicaciones, y garantizar que los datos que fluyen hacia el gemelo digital sean confiables y oportunos. Sin esta capa de observabilidad, incluso el modelo predictivo más sofisticado operará con información incompleta o imprecisa.

La pregunta ya no es si adoptar gemelos digitales, sino cómo escalar su implementación con la visibilidad y control necesarios para garantizar resultados confiables.

Envíanos tus datos y nos pondremos en contacto contigo para asesorarte.